.htaccess阻止坏爬虫

可以根据 HTTP_USER_AGENT 来判断它们。把自己的agent设置为常用浏览器标识,比如 “Mozilla/4.0 (compatible; MSIE 5.5; Windows NT 5.0)” ,就没办法了。

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} ^BlackWidow [OR]

RewriteCond %{HTTP_USER_AGENT} ^Bot\ mailto:rocdk890@gmail.com [OR]

RewriteCond %{HTTP_USER_AGENT} ^ChinaClaw [OR]

RewriteCond %{HTTP_USER_AGENT} ^Custo [OR]

RewriteCond %{HTTP_USER_AGENT} ^DISCo [OR]

RewriteCond %{HTTP_USER_AGENT} ^Download\ Demon [OR]

RewriteCond %{HTTP_USER_AGENT} ^eCatch [OR]

RewriteCond %{HTTP_USER_AGENT} ^EirGrabber [OR]

RewriteCond %{HTTP_USER_AGENT} ^EmailSiphon [OR]

RewriteCond %{HTTP_USER_AGENT} ^EmailWolf [OR]

RewriteCond %{HTTP_USER_AGENT} ^Express\ WebPictures .......

对Apache+php+Mysql的Web环境进行安全配置

下面是一些总结的Web环境的安全配置:

(1) 打开php的安全模式

php的安全模式是个非常重要的内嵌的安全机制,能够控制一些php中的函数,比如system(),

同时把很多文件操作函数进行了权限控制,也不允许对某些关键文件的文件,比如/etc/passwd,

但是默认的php.ini是没有打开安全模式的,我们把它打开:

safe_mode = on

(2) 用户组安全

当safe_mode打开时,safe_mode_gid被关闭,那么php脚本能够对文件进行访问,而且相同

组的用户也能够对文件进行访问。

建议设置为:

safe_mode_gid = off

如果不进行设置,可能我们无法对我们服务器网站目录下的文件进行操作了,比如我们需要

对文件进行操作的时....

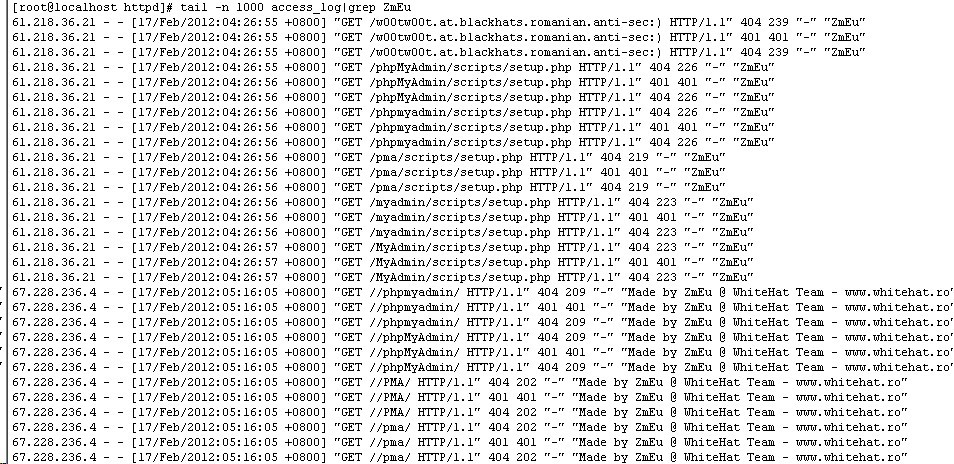

分析网站日志(转)

分析 特定url 哪些ip 访问次数分别是多少

cat /log/access.log | grep downfile | awk

‘{printf(”%s\n”,$1)}’ | sort | uniq -c | sort -n

分析apache日志得到蜘蛛ip的简单方法

cat

access_log | grep spider | awk -F ” ” ‘{print $1}’ | sort | uniq >

~/spider_ip.txt

1.查看apache进程:

ps aux | grep httpd | grep -v grep | wc

-l

2.查看80端口的tcp连接:

netstat -tan | grep "ESTABLISHED" | grep

":80" | wc -l